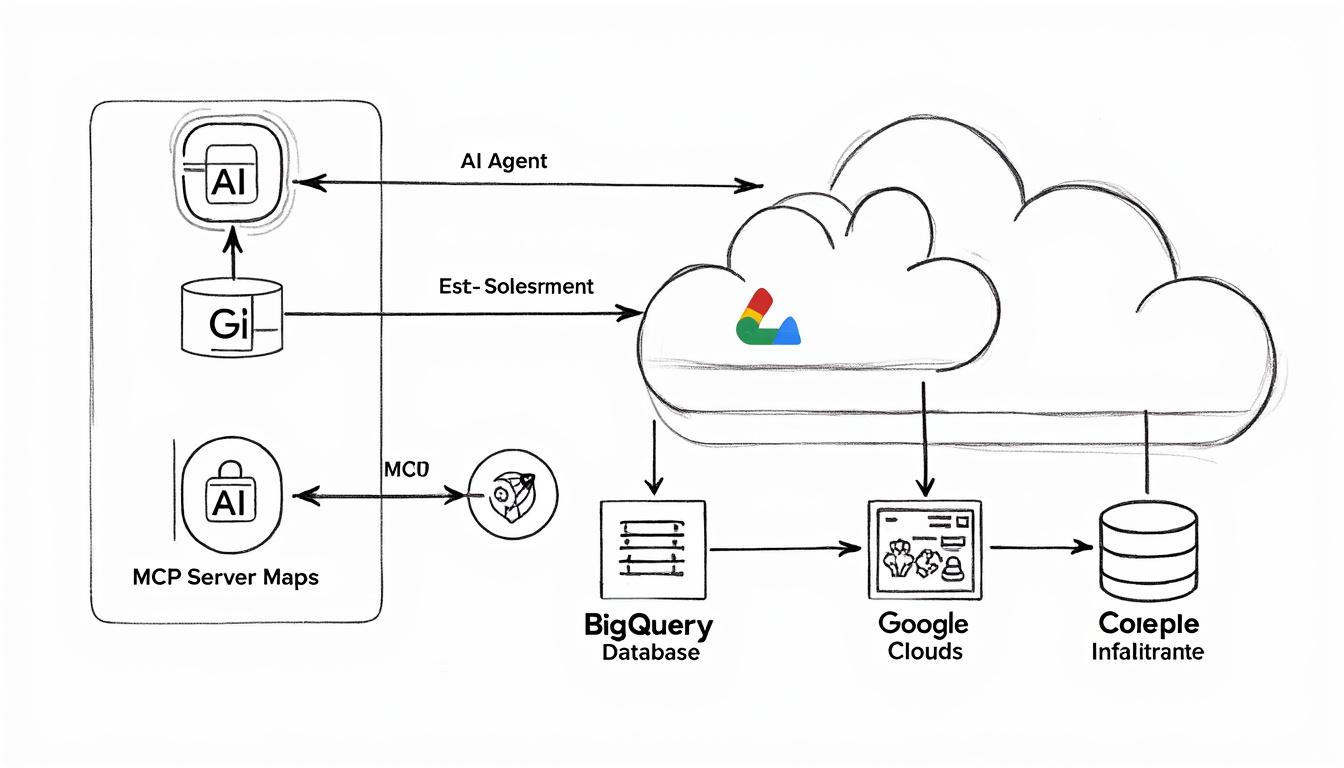

Google vient de franchir une étape clé dans l’industrialisation des agents d’IA : le déploiement de serveurs MCP entièrement gérés pour connecter directement les modèles aux services stratégiques de son écosystème. Concrètement, au lieu de bricoler des connecteurs maison entre un agent et Google Maps, BigQuery ou l’infrastructure cloud, les équipes disposent désormais d’un protocole standardisé, sécurisé et maintenu par Google. L’objectif est clair : rendre l’IA “agentique” exploitable en production, sans transformer chaque projet en chantier d’intégration interminable.

Derrière cette annonce, il y a surtout un changement de paradigme. Les modèles ne se contentent plus de générer du texte, du code ou des recommandations. Ils deviennent des agents opérationnels, capables d’interagir avec des API, de manipuler des données métiers, de piloter des ressources cloud en temps réel. Là où, jusqu’ici, un LLM restait cantonné à un rôle de “conseiller intelligent”, il commence à prendre la main sur des systèmes critiques. D’où la nécessité d’un protocole robuste comme le Model Context Protocol (MCP), conçu au départ par Anthropic et désormais poussé par les géants du cloud comme un nouveau standard d’interconnexion.

Pour les entreprises, l’impact potentiel est énorme : automatisation de tâches complexes, meilleurs temps de réponse, moins d’erreurs liées à des données obsolètes, et surtout une réduction du temps passé à développer des ponts techniques entre l’IA et les services existants. Côté Google, l’enjeu est tout aussi stratégique : verrouiller la place de ses services au cœur des futurs workflows d’agents, du géospatial à la data analytics, en passant par la gestion d’infrastructure. La question n’est plus de savoir si ces agents vont s’imposer, mais qui contrôlera les rails sur lesquels ils circulent.

- Serveurs MCP gérés par Google : accès direct à Maps, BigQuery, Compute Engine et Kubernetes Engine, sans connecteurs maison fragiles.

- Standard ouvert MCP : protocole créé par Anthropic, confié à la Linux Foundation, souvent comparé à un “USB-C pour l’IA”.

- Sécurité intégrée : IAM, audit logging et Model Armor pour limiter les risques d’injection de prompts et d’exfiltration de données.

- Extension progressive : Cloud Run, Cloud Storage, AlloyDB, Cloud SQL, Spanner, Looker et d’autres services prévus dans la phase suivante.

- Stratégie business : Google se positionne comme plateforme prête pour les agents, avec une promesse de réduction des coûts d’intégration.

Google déploie ses serveurs MCP : un nouvel OS pour les agents d’IA connectés à ses services

Le déploiement par Google de serveurs MCP entièrement gérés change la manière dont les agents d’IA consomment les services cloud et grand public. Au lieu d’un patchwork de scripts, webhooks et middlewares, les entreprises disposent désormais d’un point d’entrée unifié pour connecter leurs agents à des briques comme Google Maps, BigQuery, Compute Engine ou Kubernetes Engine. Cette approche transforme l’écosystème Google en véritable “système d’exploitation” pour agents, où chaque service devient un module accessible via un même protocole.

Un cas type permet de mesurer l’impact : une PME de logistique, appelons-la TransRoute, souhaite créer un agent d’IA capable d’optimiser ses tournées, de surveiller les coûts, et d’ajuster automatiquement les ressources serveurs en fonction des pics de demande. Avant les serveurs MCP, son équipe devait intégrer manuellement l’API Maps, écrire une couche pour interroger BigQuery, sécuriser les appels à Compute Engine, et maintenir le tout à chaque mise à jour. Désormais, TransRoute peut brancher son agent directement sur les serveurs MCP de Google, avec un cadre standardisé pour l’authentification, la gestion des permissions et la journalisation.

Google insiste aussi sur un point : les serveurs MCP sont gérés et maintenus par ses équipes. Cela signifie que les développeurs ne se retrouvent plus à courir derrière les changements de version d’API ou les subtilités d’authentification. Ils intègrent une fois, via le protocole MCP, et bénéficient ensuite des évolutions du côté Google sans refactoriser leurs agents tous les six mois. Pour des organisations qui multiplient les projets IA, cette stabilité est un levier de productivité autant qu’un atout de résilience.

Autre effet direct : le temps entre une idée d’agent et un prototype opérationnel se réduit. Là où un POC demandait des semaines de câblage technique, il devient possible de se concentrer sur le cœur métier : quelles actions l’agent doit-il vraiment effectuer, quelles données doit-il consulter, quels garde-fous instaurer. L’IA ne remplace pas le travail, elle accélère surtout ceux qui savent où ils veulent aller, et ces serveurs MCP rendent cette accélération beaucoup plus accessible.

En filigrane, ce déploiement montre comment Google prépare son écosystème à un futur où chaque application sérieuse embarquera un ou plusieurs agents. Dans ce paysage, les serveurs MCP jouent le rôle de rails standardisés, tandis que les services comme Maps ou BigQuery fournissent le carburant de données. C’est cette combinaison – standard ouvert + services propriétaires – qui donne à Google un avantage stratégique sur les prochaines années.

Pourquoi le Model Context Protocol devient la colonne vertébrale des intégrations IA

Le Model Context Protocol (MCP) a été imaginé par Anthropic pour résoudre un problème très concret : comment permettre à des modèles d’IA d’accéder à des outils, fichiers et bases de données hétérogènes sans réinventer la roue à chaque projet. L’image souvent utilisée – un “USB-C pour l’IA” – n’est pas qu’un slogan : MCP définit un langage commun pour que les agents puissent découvrir, appeler et exploiter des services externes de manière structurée. Google s’appuie sur cette brique pour rendre ses services “plug-and-play” côté agents.

Avant MCP, chaque intégration ressemblait à un bricolage sur mesure. Un connecteur pour tel CRM, un autre pour tel outil d’analytics, un troisième pour le cloud. Résultat : dette technique, bugs difficiles à diagnostiquer, et un frein évident à la généralisation des agents d’IA en production. En s’alignant sur MCP – désormais confié à la Linux Foundation, ce qui renforce son statut de standard ouvert – Google évite le piège du format propriétaire tout en gardant la main sur la qualité de ses intégrations.

Pour un développeur, cela se traduit par un workflow plus simple : l’agent annonce qu’il parle MCP, le serveur MCP de Google expose ses capacités (outils disponibles, schémas attendus, types de requêtes possibles), et l’agent peut ensuite orchestrer des actions en s’appuyant sur cette description. Le rôle du protocole n’est pas de décider “quoi faire”, mais de fournir un cadre propre, documenté et testable pour le “comment faire”. On sort du mode bidouille pour entrer dans une logique d’architecture.

Ce positionnement est cohérent avec la montée en puissance de ce que beaucoup appellent l’“agentic AI” : des systèmes capables de planifier, d’agir, de se corriger, en s’appuyant sur des outils externes. Sans un protocole unifié, chaque nouvel outil rajoute du chaos. Avec MCP, chaque outil compatible devient une brique interchangeable de la boîte à outils des agents. C’est précisément ce qui rend le choix de Google intéressant : en adoptant MCP à grande échelle, le groupe participe à stabiliser l’écosystème au lieu d’ajouter un standard propriétaire de plus.

MCP Google Services : comment Maps, BigQuery et l’infrastructure cloud deviennent pilotables par des agents IA

Au lancement, Google ouvre ses serveurs MCP à quatre services majeurs : Google Maps, BigQuery, Compute Engine et Kubernetes Engine. Chacun répond à un besoin métier précis et permet de passer d’une IA “qui répond” à une IA “qui agit”. Le point commun : les agents accèdent à des données ou des capacités d’exécution en temps réel, sans transférer massivement les informations dans le modèle, ce qui réduit à la fois les risques de sécurité et les coûts.

Google Maps est sans doute le plus parlant pour le grand public, mais il devient aussi un outil stratégique pour les agents. Un assistant peut désormais demander des itinéraires, récupérer des informations sur des points d’intérêt, intégrer des données météo ou de trafic circulant, et construire des recommandations géolocalisées sans halluciner. Un agent de conciergerie peut par exemple proposer un restaurant adapté à des contraintes de temps, de budget et de distance, en se basant sur les données géospatiales mises à jour par Google, plutôt que sur une mémoire approximative.

BigQuery joue un autre rôle : celui de la passerelle vers la donnée métier. Grâce au serveur MCP dédié, un agent peut interpréter les schémas de tables, générer des requêtes SQL adaptées, lancer des analyses et renvoyer des insights à un utilisateur métier, le tout sans extraire les données de l’environnement sécurisé. Dans le cas de notre entreprise fictive TransRoute, l’agent peut par exemple analyser en direct les historiques de livraisons, identifier les zones à forte dérive de coûts, et proposer des ajustements opérationnels chiffrés.

Compute Engine et Kubernetes Engine amènent la couche d’action sur l’infrastructure. Un agent peut créer une instance, la dimensionner, la démarrer ou l’arrêter en fonction d’indicateurs métiers ou de charge technique. Sur Kubernetes, il peut ajuster le nombre de pods, déclencher un déploiement, ou surveiller des métriques clés. Autrement dit, l’IA ne se contente pas d’alerter sur un problème de charge, elle peut proposer – et exécuter – un plan d’action, dans les limites définies par l’équipe ops.

En combinant ces quatre services, Google offre déjà un terrain de jeu suffisant pour construire des agents qui couvrent tout un cycle : analyse des données (BigQuery), décision (logique d’agent), action sur le terrain (Maps pour la logistique ou la relation client locale) et adaptation de l’infrastructure (Compute/Kubernetes) pour absorber la demande. C’est cette continuité qui rend la démarche intéressante pour les entreprises qui veulent des résultats concrets, pas seulement des démonstrations.

Exemples concrets d’agents IA tirant parti des serveurs MCP Google

Pour mesurer la portée réelle de ces serveurs MCP, il suffit de regarder des scénarios applicatifs que de nombreux métiers rencontrent déjà. Prenons une chaîne de retail qui souhaite optimiser ses livraisons dernier kilomètre. Un agent IA connecté à Google Maps via MCP peut calculer des tournées en intégrant trafic, météo et horaires d’ouverture des points de retrait. En parallèle, via BigQuery, il analyse l’historique des retards et des coûts. Enfin, à travers Compute Engine, il ajuste la capacité de calcul utilisée pour ces simulations pendant les pics saisonniers, sans intervention manuelle.

Autre scénario : une plateforme SaaS d’analytics marketing qui promet des recommandations “en temps réel”. L’agent IA peut se brancher sur BigQuery pour interroger les données de campagnes, détecter des anomalies de conversion, puis déclencher, via Kubernetes Engine, un redéploiement d’un microservice d’optimisation si la charge augmente. En pratique, cela signifie que l’infrastructure suit automatiquement la demande, tout en gardant le contrôle via les politiques IAM et les logs d’audit Google Cloud.

Ces cas montrent qu’on n’est plus seulement dans l’IA conversationnelle, mais dans une IA opératrice, capable d’orchestrer des systèmes complexes. Le serveur MCP joue ici le rôle de traducteur entre le langage des agents et la réalité des API cloud. À condition bien sûr de définir des garde-fous clairs : limites d’actions, plages horaires, validations humaines pour certaines opérations critiques. L’enjeu n’est pas de laisser l’IA tout piloter, mais de lui confier les bons leviers au bon endroit.

Sécurité, IAM et Model Armor : les garde-fous indispensables pour des agents IA branchés sur Google Cloud

Dès que des agents peuvent agir sur des environnements de production et accéder à des données sensibles, la question n’est plus “est-ce que ça marche ?”, mais “est-ce que c’est maîtrisé ?”. Google a intégré à ses serveurs MCP un ensemble de couches de sécurité et de gouvernance qui s’appuient sur les briques déjà connues des équipes cloud : IAM, audit logging, gestion d’API via Apigee et protections spécifiques via Model Armor. L’objectif est double : empêcher l’agent de sortir de son périmètre, et tracer précisément ce qu’il fait.

Google Cloud IAM reste le centre de gravité. Chaque agent, chaque serveur MCP, chaque ressource cloud se voit attribuer des rôles et des permissions explicites. Un agent n’a pas le droit universel de lancer des instances ou de lire toutes les tables BigQuery. Il dispose de droits limités, alignés sur les besoins métiers. Cette approche par le moindre privilège est essentielle : elle transforme un éventuel comportement déviant en incident limité, pas en catastrophe globale.

L’audit logging ajoute la couche de traçabilité. Toutes les actions déclenchées via les serveurs MCP peuvent être journalisées : quelles requêtes ont été envoyées, quelles ressources ont été modifiées, quel agent ou quel utilisateur en est à l’origine. Pour une équipe de sécurité ou de conformité, cette visibilité permet de reconstituer un scénario en cas de doute, mais aussi de prouver que les processus respectent les politiques internes et les cadres réglementaires, ce qui devient critique dans des secteurs comme la finance ou la santé.

La nouveauté la plus marquante se situe cependant du côté de Model Armor. Cette technologie se comporte comme un pare-feu spécialisé pour les agents et les modèles, avec un focus sur des menaces propres à l’IA : injection de prompt, tentatives d’exfiltration de données à travers les réponses, exploitation de failles logiques. Plutôt que de laisser chaque équipe réinventer des règles de filtrage, Model Armor fournit une base de politiques que les entreprises peuvent adapter, afin de filtrer les requêtes et les réponses transitant par les agents.

Apigee ferme la boucle en permettant de transformer des API existantes en serveurs MCP tout en appliquant les mêmes politiques de sécurité que pour les applications classiques. Cela évite de créer une zone grise “réservée aux agents” où les règles seraient plus permissives. Au contraire, les agents se voient appliquer les mêmes contrôles de quotas, d’authentification, de monitoring. Automatiser sans comprendre reviendrait à accélérer ses erreurs ; ici, l’idée est de garder la main sur la structure tout en laissant l’IA automatiser l’exécution.

| Composant | Rôle dans l’écosystème MCP | Bénéfice business clé |

|---|---|---|

| Google Cloud IAM | Gestion des identités et des permissions pour agents, serveurs MCP et ressources cloud. | Réduction des risques d’accès non autorisé et meilleure conformité. |

| Audit Logging | Journalisation détaillée des actions réalisées via les agents et les serveurs MCP. | Traçabilité complète, enquêtes facilitées et preuves pour les audits. |

| Model Armor | Protection contre l’injection de prompt et l’exfiltration de données dans les flux IA. | Réduction des attaques spécifiques aux modèles et renforcement de la confiance. |

| Apigee | Transformation des API en serveurs MCP avec politiques de sécurité unifiées. | Réutilisation des pratiques API existantes et simplification de la gouvernance. |

Pour une entreprise qui envisage de laisser un agent toucher à son chiffre d’affaires, à ses campagnes ou à son infrastructure, ces garde-fous ne sont pas optionnels. Ils deviennent la condition pour passer du prototype “cool” à une mise en production contrôlée. La vraie maturité ne se mesure pas au nombre d’agents déployés, mais à la capacité à expliquer précisément ce qu’ils peuvent faire, ce qu’ils ne peuvent pas faire, et comment leurs actions sont supervisées.

Roadmap de Google : extension MCP à tout l’écosystème et montée en puissance des agents

Google a choisi un déploiement progressif. Les serveurs MCP pour Maps, BigQuery, Compute Engine et Kubernetes Engine sont disponibles en preview publique pour les clients entreprise, sans surcoût par rapport à l’usage classique de ces services. Le passage en disponibilité générale est annoncé pour le début de l’année 2026, ce qui laisse une fenêtre de test confortable aux équipes qui veulent expérimenter sans s’engager sur des SLA définitifs.

La feuille de route ne s’arrête pas là. Google prévoit d’étendre le support MCP à une large partie de son catalogue : Cloud Run pour les applications conteneurisées sans serveur, Cloud Storage pour les fichiers, AlloyDB, Cloud SQL et Spanner pour les bases de données, Looker pour la couche analytics, Security Operations et Cloud Logging pour la dimension cybersécurité et observabilité. Autrement dit, presque chaque brique clé de la plateforme Google Cloud est destinée à devenir compatible MCP.

Pour un entrepreneur ou un décideur digital, cela signifie que l’IA ne sera plus cantonnée à un département isolé. Un même agent pourra, demain, déclencher un déploiement sur Cloud Run, vérifier des logs via Cloud Logging, corréler des incidents avec Security Operations, et remonter des insights dans un tableau de bord Looker. Le tout dans un cadre unifié, plutôt que via une mosaïque d’intégrations artisanales. On se rapproche d’une architecture où l’agent devient un collaborateur transverse, connecté à la plupart des couches du système d’information.

Google a également rejoint des initiatives comme l’Agentic AI Foundation, ce qui montre une volonté de participer à la définition des bonnes pratiques autour de ces agents capables d’agir. En contribuant à l’évolution du protocole MCP via l’open source, la firme sécurise un double avantage : profiter des contributions de la communauté tout en influençant le standard sur lequel elle bâtit ses propres services. Ce n’est pas simplement un pari technique, mais un positionnement sur la gouvernance même de l’écosystème IA.

Dans cette perspective, les entreprises qui investissent tôt dans les serveurs MCP Google se donnent une longueur d’avance. Elles peuvent tester des cas d’usage limités, documenter ce qui fonctionne, ce qui coince, affiner leurs politiques de sécurité, et surtout bâtir une culture interne autour des agents. La transition ne se fera pas en un clic, mais ceux qui auront pris le temps d’expérimenter auront un avantage tangible lorsque MCP couvrira la quasi-totalité des services Google.

Comment préparer son organisation à l’arrivée massive des agents basés sur MCP

Plutôt que de viser directement un projet “full agent” branché sur tout Google Cloud, il est souvent plus efficace de commencer par un périmètre réduit. Par exemple, un agent connecté uniquement à BigQuery pour aider l’équipe marketing à générer des rapports ad hoc. L’enjeu n’est pas de montrer tout ce que l’agent peut faire, mais d’apprendre comment le cadrer, le monitorer, et l’intégrer dans les routines existantes. C’est cette approche incrémentale qui permet d’éviter les effets de mode et les déceptions rapides.

Une bonne pratique consiste à créer un “catalogue d’actions” autorisées pour l’agent, avec pour chacune : la ressource visée, la justification métier, le niveau de risque, et la logique de validation éventuelle. Ce catalogue sert ensuite de base aux configurations IAM, aux politiques Model Armor et aux contrôles dans Apigee. On construit ainsi un cadre de jeu clair : l’agent n’est pas une boîte noire toute-puissante, mais un automate qui agit dans un périmètre défini et documenté.

Enfin, il ne faut pas oublier la dimension humaine. Les agents MCP ne remplaceront pas les équipes, mais modifieront leurs routines. Un ops devra apprendre à collaborer avec un agent qui propose un scaling automatique, un analyste marketing avec un agent qui lui met sous le nez des insights prêts à l’emploi. La réussite d’un projet MCP se joue autant dans cette acculturation que dans la qualité du code ou de la configuration cloud. Les organisations qui l’auront compris transformeront ces agents en véritables leviers de croissance, plutôt qu’en gadgets de démo.

Processus concret pour exploiter les serveurs MCP Google dans un projet d’agent IA

Pour rendre tout cela exploitable, il est utile de poser un processus simple, reproductible, pour intégrer les serveurs MCP Google dans un projet réel. L’idée n’est pas de créer une usine à gaz, mais une suite d’étapes claires qui réduisent le risque de se perdre entre vision stratégique et implémentation technique. Un bon fil rouge consiste à partir d’un problème métier précis et à dérouler jusqu’à l’architecture d’agent la plus simple possible pour le résoudre.

Imaginons une startup SaaS, DataFlow, qui veut créer un agent chargé de générer des rapports automatisés pour ses clients. Elle s’appuie sur BigQuery pour la donnée, Looker pour certains dashboards, et Cloud Run pour héberger quelques microservices. Son objectif : proposer à ses clients un “analyste virtuel” capable de répondre à des questions du type “Quelles campagnes ont le meilleur ROI ce mois-ci ?” ou “Où perd-on le plus de leads dans le funnel ?”, sans mobiliser en continu l’équipe data.

Le processus peut se découper ainsi :

- 1. Cadrer le problème : lister les questions récurrentes des clients, les décisions qui en découlent, et les données nécessaires.

- 2. Cartographier les services Google utiles : BigQuery pour les tables de tracking, éventuellement Looker pour certains modèles, Cloud Run si l’agent doit déclencher des traitements spécifiques.

- 3. Définir les actions autorisées : lecture de certaines tables, génération de requêtes analytiques, mais pas de modification de données en base.

- 4. Configurer les serveurs MCP : activer le serveur BigQuery MCP, sécuriser l’accès via IAM, paramétrer l’audit logging.

- 5. Intégrer l’agent via l’Agent Development Kit : connecter l’agent au serveur MCP, tester les premiers flux de requêtes/réponses.

- 6. Mettre en place les garde-fous : règles Model Armor pour éviter les requêtes non pertinentes, quotas via Apigee si besoin.

- 7. Itérer avec des utilisateurs pilotes : observer où l’agent apporte vraiment de la valeur, et où il nécessite un ajustement ou une validation humaine.

Ce type de démarche permet de garder le contrôle tout en avançant vite. Plutôt que d’imaginer un “super agent” omnipotent, on construit un agent spécialisé, aligné sur un KPI concret (temps gagné, meilleure qualité des décisions, réduction des tickets de support). Une fois ce premier bloc stabilisé, DataFlow pourra envisager de connecter l’agent à d’autres services MCP, par exemple pour lancer des traitements sur Cloud Run ou enrichir ses analyses avec des données externes.

Au final, les serveurs MCP de Google sont surtout un outil. Leur vraie valeur dépend de la clarté avec laquelle une entreprise définit ses priorités : quels processus méritent d’être automatisés, quels risques sont acceptables, quels résultats sont attendus. Un protocole standard, des services puissants et des garde-fous solides créent un terrain favorable. Reste à chaque équipe de décider comment l’exploiter intelligemment.

Qu’est-ce qu’un serveur MCP Google dans le contexte des agents d’IA ?

Un serveur MCP Google est un point d’accès standardisé, basé sur le Model Context Protocol, qui permet à un agent d’IA de se connecter à un service Google comme Maps, BigQuery ou Compute Engine. Au lieu de développer un connecteur spécifique, l’agent dialogue via MCP et peut découvrir les capacités exposées, envoyer des requêtes et recevoir des réponses dans un format unifié, avec la sécurité et la gouvernance de Google Cloud intégrées.

Quels services Google sont déjà compatibles MCP ?

Au lancement, Google propose des serveurs MCP entièrement gérés pour quatre services : Google Maps (données géospatiales et POI), BigQuery (requêtes sur données d’entreprise), Compute Engine (gestion de machines virtuelles) et Kubernetes Engine (pilotage de clusters Kubernetes). Google a annoncé l’extension progressive du support MCP à d’autres services comme Cloud Run, Cloud Storage, AlloyDB, Cloud SQL, Spanner, Looker, Security Operations et Cloud Logging.

Comment la sécurité est-elle gérée pour les agents IA utilisant les serveurs MCP ?

La sécurité repose sur plusieurs couches : IAM définit les permissions des agents et des serveurs MCP, l’audit logging journalise toutes les actions pour la traçabilité, Model Armor filtre les requêtes et réponses pour limiter l’injection de prompt et l’exfiltration de données, et Apigee permet d’appliquer les mêmes politiques de sécurité que pour les API classiques. L’ensemble vise à s’assurer que l’agent agit dans un périmètre maîtrisé et que ses actions restent explicables.

Les serveurs MCP Google entraînent-ils des coûts supplémentaires ?

Selon les informations communiquées, les serveurs MCP gérés par Google sont proposés en preview publique sans surcoût pour les clients qui utilisent déjà les services concernés. Les coûts restent donc liés à la consommation des services sous-jacents (BigQuery, Maps, Compute Engine, etc.). Il est conseillé de surveiller la facturation en phase de test, notamment pour les requêtes intensives ou les scénarios qui déclenchent des ressources cloud supplémentaires.

Comment démarrer concrètement avec MCP si mon équipe n’a pas encore d’expérience ?

La meilleure approche consiste à choisir un cas d’usage limité, centré sur un service comme BigQuery ou Maps, et à construire un agent spécialisé autour de ce besoin. Il faut définir clairement les actions autorisées, configurer IAM et l’audit logging, puis intégrer l’agent via l’Agent Development Kit ou un framework compatible MCP. En impliquant quelques utilisateurs pilotes, vous pouvez affiner rapidement les prompts, les garde-fous et les métriques de succès avant d’étendre l’usage à d’autres services et à d’autres équipes.